Slide Share : )

Leemos On-line:)

Contador

Trabajo Slide Share

LAS AVES

Ave es el nombre común para cualquier miembro de cualquiera de las clases de vertebrados que incluye animales con plumas. Todas las aves adultas tienen plumas, aunque algunos tipos como el pelicano, el martín pescador, el pájaro carpintero y el arrendajo están completamente desnudos cuando salen del huevo.

El termino pájaro se aplica a cualquier ave con capacidad de volar y de pequeño tamaño.

Las aves comparten ciertos rasgos con los mamíferos, como ser animales de sangre caliente y tener un corazón de cuatro cámaras. Sin embargo, se diferencian de estos en que evolucionaron de los dinosaurios mucho tiempo después de que se separaran los grupos de reptiles y mamíferos. Como la mayoría de los reptiles y algunos mamíferos primitivos, se desarrollan a partir de embriones localizados en huevos que están fuera del cuerpo materno.

LOS HUEVOS DE LAS AVES:

- TIENE CÁSCARAS DURAS

- SON FUERTES EN LOS DE LAS ESPECIES GRANDES

- BASTANTE FRÁGILES EN LAS DE PEQUEÑO TAMAÑO.

3)WMV y MSMM

4)Audio: .aif, .aifc, .aiff .asf, .au, .mp2, .mp3, .mpa, .snd, .wav, and .wma

Imagen: .bmp, .dib, .emf, .gif, .jfif, .jpe, .jpeg, .jpg, .png, .tif, .tiff, and .wmf

Video: .asf, .avi, .m1v, .mp2, .mp2v, .mpe, .mpeg, .mpg, .mpv2, .wm, and .wmv

5)Para ver la imagen hacer clic !

Las Catastrofes Naturales

Catástrofes naturales: la amenaza latente

En nuestro país, donde terremotos, inundaciones y erupciones volcánicas son amenazas de alto riesgo, los organismos oficiales encargados de prevenir desastres dan señales de impotencia

Aunque la Argentina se encuentra en un lugar privilegiado del planeta que la protege de las peores furias de la naturaleza -huracanes, tsunamis, maremotos-, las catástrofes naturales también amenazan nuestro territorio. Menos espectaculares que los que azotaron recientemente las costas de Asia y de Estados Unidos, estos fenómenos han provocado, de todos modos, cuantiosas pérdidas humanas y económicas (sólo en términos de inundaciones, se calcula que el impacto económico anual para las décadas 2030-2040 será de cien millones de dólares, cifra que se triplicaría cuatro décadas después).

Pero el lamentable historial de terremotos, inundaciones, avalanchas y erupciones volcánicas que arrastra nuestro país no ha logrado definir una política nacional capaz de avanzar en materia de prevención y alerta temprana. De hecho, el Sistema Federal de Emergencias (Sifem), creado en 1999 para centralizar y coordinar las acciones de los diferentes organismos competentes en caso de catástrofes, parece no terminar de concretarse.

El Sifem se mantuvo bajo la órbita de la Jefatura de Gabinete hasta que en 2002 fue transferido a la Secretaría de Seguridad Interior, dependiente del Ministerio del Interior. Sin embargo, el impacto de su labor en todos estos años es desconocido por especialistas de medioambiente. Incluso, fuentes de la secretaría de Ambiente y Desarrollo Sustentable la calificaron como "una estructura de cartón pintado".

"Lamentablemente, el Sifem sigue siendo una dependencia que parecería no existir. Su principal función es la prevención, pero sus acciones no se perciben públicamente, lo que es extremadamente grave en un organismo de esta naturaleza", expresó Raúl Montenegro, biólogo, ganador del premio Nobel alternativo en 2004 y presidente de la Fundación para la defensa del medioambiente.

Mientras tanto, en la zona con mayor vulnerabilidad sísmica del país -las regiones centro-oeste y noroeste-, nadie sabe cuántos cumplen con las normas de construcción sismorresistentes establecidas por el Instituto Nacional de Prevención Sísmica (Inpres) y la policía edilicia, encargada de controlar, no cuenta con personal suficiente; la actividad volcánica es deficientemente monitoreada (no más de diez ciudades conocen cuán estables son sus zonas montañosas) y, en cuanto a las inundaciones, las obras de infraestructura no pueden garantizar un freno eficaz para el avance del agua.

Como si ese panorama no arrojara suficientes sombras, el cambio climático y el calentamiento global han comenzado a acelerar sus relojes también sobre nuestras tierras.

Los estudios iniciados durante el año último por la Secretaría de Ambiente y Desarrollo Sustentable pronostican para los próximos años el aumento de las tormentas severas, así como una mayor intensidad y recurrencia de crecidas e inundaciones. "Los efectos adversos también incluyen la disminución de la disponibilidad de agua en los oasis andinos para consumo humano, riego y generación hidroenergética; el retroceso de glaciares en los Andes patagónicos y, en otras zonas cordilleranas, la afectación de ecosistemas y la extensión espacial del radio de enfermedades provocadas por el aumento de las temperaturas", explica Hernán Carlino, jefe de la Unidad de Cambio Climático de esa secretaría. Avance del agua

Pero las tormentas no serán la única causa de las inundaciones previstas para las próximas décadas. "La tendencia indica que aumentará el nivel del mar a razón de cuatro centímetros por década. A medida que el nivel esté más alto, las inundaciones tendrán mayor alcance. Suponemos que esto va a ocurrir principalmente en la costa del Río de la Plata, porque es baja", explica el profesor de Climatología Vicente Barros, autor del libro El cambio climático global (Libros del Zorzal).

Actualmente, la zona costera más vulnerable es la de la Bahía de Samborombón, cuya área inundable tiene escasa población y actividad económica. Pero el aumento del nivel de las aguas provocaría crecidas cada vez más frecuentes sobre superficies hoy dedicadas a la ganadería y la agricultura. Incluso, se verían afectadas ciudades como General Lavalle y San Clemente del Tuyú. De acuerdo con el libro de Barros, también aumentará la frecuencia de inundaciones provocadas por sudestadas y las zonas más afectadas serán la costa sur del gran Buenos Aires y el partido de Tigre.

De la misma manera, hacia el sur de la ciudad y en las zonas ribereñas de los ríos Matanza y Reconquista, donde abundan grupos poblacionales con alta vulnerabilidad social, aumentarán considerablemente las posibilidades de exposición a las inundaciones recurrentes.

"Las ciudades del noreste argentino también serán muy vulnerables en este sentido, porque allí se espera una mayor frecuencia en las precipitaciones. Además, generalmente se trata de ciudades pobres, sin recursos suficientes para enfrentar la situación", sostiene Barros.

El abrupto aumento de población que se dio en ciertas ciudades argentinas propició que la gente se fuera asentando, incluso, en los valles de algunos ríos. "Así ocurrió, por ejemplo, en Resistencia, Goya, Reconquista, Formosa, Clorinda, Villa Paranacito, Gualeguaychú, Concordia y Concepción del Uruguay. En todos estos casos, buena parte de la ciudad fue construida sobre el valle de inundación del río y el agua los invade con facilidad", explica Dora Goniadzki, directora del Sistema de Información de Alerta Hidrológico del Instituto Nacional del Agua, que monitorea la cuenca del Plata, especialmente de los ríos Paraná, Paraguay y Uruguay.

Goniadzki cita los casos de Villa Paranacito y Goya como ejemplares. "Allí están preparados para convivir con el río. Se sabe que las cosas pueden pasar. Sus habitantes sólo necesitan un aviso de alerta lo más temprano posible como para poder manejarse." La especialista agrega que la mayoría de las ciudades antes mencionadas cuentan con obras para la contención de la crecida de los ríos. "Pero una obra siempre implica ser más vulnerable: porque puede fallar, porque puede llover más de lo previsto, o porque la inundación puede llegar por otro lado y afectar a otros sectores. Por eso es importante la combinación de un adecuado sistema de alerta y monitoreo con obras de contención, pero también con eficaces medidas de contingencia para paliar el efecto de las inundaciones."

Según algunos cálculos, se considera que los gastos ocasionados por las inundaciones de 2001 en Santa Fe alcanzaron los mil millones de pesos. Bastante lejos del costo económico que dejó la gran inundación en la cuenca del Plata de 1983: 2000 millones de dólares, de acuerdo con el profesor Vicente Barros, que estima el daño actual de las sudestadas en alrededor de 30 millones de dólares anuales. Suponiendo que no hubiera cambios demográficos, socioeconómicos ni de valor de los bienes, se proyecta que el impacto económico anual de las inundaciones para las décadas 2030-2040 será de cien millones de dólares, cifra que se triplicaría cuatro décadas después. Más dudas que certezas

Menos previsible que una inundación, la actividad sísmica en nuestro país se encuentra concentrada en una franja que atraviesa las provincias de Mendoza, San Juan, Salta, Jujuy, Catamarca y Córdoba.

Con un historial de 400 años de fenómenos de diferente intensidad, el tema no ha logrado instalarse con la relevancia que merece, tal vez porque la mayoría de esos fenómenos no ha afectado zonas densamente pobladas.

Hasta hoy, el terremoto de mayor magnitud (8 puntos) se registró en el noroeste de San Juan, el 27 de octubre de 1894. Pero el más devastador ocurriría 50 años más tarde, el 15 de enero de 1944, en la ciudad de San Juan. El movimiento telúrico destruyó el 80 por ciento de las construcciones existentes y ocasionó unas diez mil víctimas fatales.

Sesenta años después, aún no es cosa fácil predecir la proximidad de un terremoto. "Los Angeles invirtió miles de millones de dólares en este sentido y no pudo avanzar demasiado en la predicción de los terremotos. Lo que nos puede resultar útil es el análisis de la recurrencia histórica", explica Víctor Ramos, profesor de Tectónica andina en la UBA.

"El país cuenta con el Instituto Nacional de Prevención Sísmica (Inpres), ubicado en San Juan, cuya tarea fundamental es alertar y verificar que las construcciones cuenten con sistemas adecuados de prevención sísmica, de acuerdo con la zonación de riesgo sísmico del país. Pero este es un país en vías de desarrollo, y los recursos del Inpres no son los que deberían ser", agrega Ramos.

El Inpres también se encarga de llevar un registro de los fenómenos que tienen lugar en diferentes zonas del país. Pero el historial argentino es insuficiente para predecir el comportamiento de la tierra.

"Con un catálogo histórico de sismos se pueden tener ciertos parámetros. Pero el nuestro es muy pequeño: no llega a cuatrocientos años. Tenemos casos paradigmáticos como el de China, que cuenta con un catálogo sísmico de 2500 años", comenta Mario Araujo, jefe de investigaciones sismológicas del Inpres.

"Durante el siglo XX tuvimos una seguidilla de terremotos, pero eso no nos permite predecir el comportamiento de este siglo, porque no se trata de algo periódico", considera el especialista.

Frente a esto, se vuelve doblemente fundamental el desarrollo de sistemas preventivos que informen sobre las medidas que deben tomarse frente a un terremoto. "Existe una ley nacional de educación para la prevención sísmica. Entre otras cosas, establece que el tema debe incluirse en todos los programas escolares. Pero no se aplica con demasiada fuerza. De todas maneras, las ciudades que se consideran ubicadas en lugares de alta peligrosidad sísmica, como son las provincias de San Juan y Mendoza, toman sus recaudos. A mí me preocupa que un terremoto de magnitud 6,5 o más se produzca en una ciudad como Córdoba, o en otras zonas serranas, donde la preparación es claramente deficiente", agrega Araujo, también profesor de Sismología de la Universidad de San Juan.

Aun en las zonas consideradas como altamente peligrosas, nadie sabe a ciencia cierta si las construcciones son resistentes a los sismos. De acuerdo con el licenciado Araujo, no se puede precisar cuántas cumplen con los requisitos establecidos por las normas Inpres-Cirsoc para construcciones sismorresistentes. Pero la policía edilicia, encargada de controlar, no cuenta con personal suficiente. Ciudades como Córdoba, Salta y Jujuy encarnan desafíos muy importantes en esta materia. Una actividad silenciosa

Tan difícil como predecir un terremoto resulta la comprensión del comportamiento de un volcán.

En nuestro país hay una decena de volcanes cuya silenciosa actividad es un enigma amenazante. ¿Cuándo entrarán en erupción? Nadie lo sabe.

"En el momento de analizar la cantidad de volcanes que podrían afectarnos -dice Víctor Ramos-, debemos tener en cuenta a los ubicados en el lado chileno, porque el efecto de los vientos dominantes hace que esparzan sus cenizas sobre nuestro territorio. Las cenizas volcánicas pueden dañar las comunicaciones, los cultivos y la salud de la población sobre la que se esparcen.

Ramos recuerda el episodio del volcán Hudson, cuyas cenizas en 1993 obligaron a cerrar el aeropuerto de Comodoro Rivadavia, y el de las del Lonquimay, que en 1988 provocaron el mismo problema, durante ciertos períodos, en los aeropuertos de Bariloche y Neuquén.

El organismo dedicado a monitorear la actividad volcánica es el Servicio Geológico Minero Argentino (Segemar). Pero la falta de recursos económicos dificulta seriamente la actividad y aunque, tal como informa Omar Lapido -director de Geología Ambiental y Aplicada del Segemar-, los datos de las erupciones históricas nos permitirían detectar patrones de recurrencia, la inmediatez que impone la problemática económica hace que tal vez se avance en la investigación de un volcán pero no en los otros.

"Hay volcanes monitoreados constantemente -dice Lapido-, como el Copahue o el Planchón Peteroa; esto permite otro nivel de previsión. Pero lo más costoso no es el equipo en sí, sino procurar que una persona envíe registros continuamente o, en caso de que el equipo sea automático, que cuide que esa automatización no se corte", informa .

Para el especialista, los recursos destinados a monitorear e investigar la actividad volcánica no sólo son escasos, sino que al estar distribuidos entre numerosos proyectos pierden impulso. "Esto es verdaderamente preocupante, porque se trata de un fenómeno que puede afectar bienes económicos y vidas humanas", concluye. No sólo cuestión de forma

Cualquiera de los eventos naturales antes mencionados (precipitaciones extremas, sismos o volcanes) pueden provocar remociones en masa, también conocidas como aluviones o avalanchas. Sin embargo, la estabilidad de la mayor parte de las zonas montañosas del país es casi un misterio. Sólo un estudio geológico puede determinarlo, aunque no más de diez ciudades en el país lo han realizado.

Uno de los casos de remociones en masa más resonantes fue el de Palma Sola, en Salta. El 5 de abril de 2001, un aluvión de agua y barro originado por fuertes lluvias causó víctimas fatales y serios daños en la región. "Suele pensarse que todas las rocas son firmes, pero una cosa es su morfología y otra, su estructura. Puede pasar que las rocas sean sedimentarias y, por ende, más propensas a las remociones en masa", asegura Omar Lapido.

El Segemar realiza estudios geocientíficos sólo en el caso de que las ciudades lo soliciten -y lo costeen-. Un estudio de peligrosidad bien detallado puede valer 150.000 pesos aproximadamente. "Una inversión más que necesaria para cualquier ciudad, si de lo que se trata es de conocer cuán firme es el terreno sobre el que está creciendo", enfatiza Lapido.

Los recientes sucesos de Nueva Orleáns demostraron cuán devastadoras pueden ser las consecuencias si la furia de la naturaleza se combina con la imprevisión estatal. Una lección que todavía no logra aprender la Argentina, privilegiada con un territorio no tan expuesto a las peores catástrofes, pero indecisa a la hora de tomar decisiones para controlar tanto los fenómenos que ya hacen sentir sus devastadores efectos como las amenazas en ciernes.

Compresion

Se recominda el win zip y win rar

(formato:.zip y .rar )

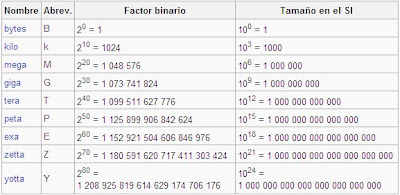

El Byte

1 B Una letra

10 B Una o dos palabras

100 B Una o dos frases

1 kB Una historia muy corta

10 kB Una página de enciclopedia (tal vez con un dibujo simple)100 kB Una fotografía de resolución mediana

1 MB Una novela

10 MB Dos copias de la obra completa de Shakespeare

100 MB 1 metro de libros en estantería

1 GB Una furgoneta llena de páginas con texto

1 TB 50.000 árboles de papel

10 TB La colección impresa de la biblioteca del congreso de EE.UU.

- Usar el limpiardor de disco

- tener copias de seguridad

- Eliminar periodicamente la información inútil o poco utilizada

- Comprimir la información poco utilizada para mejorar el uso del espacio en disco

- Tomar precauciones al realizar descargas de Internet, utilizando sitios confiables y previamente escaneados

- El anti-virus debe estar actualizado

¿En que mundo vivimos ? ¿De que nos sirve ?

Los propulsores de la aproximación a la Web 2.0 creen que el uso de la web está orientado a la interacción y redes sociales, que pueden servir contenido que explota los efectos de las redes, creando o no webs interactivas y visuales. Es decir, los sitios Web 2.0 actúan más como puntos de encuentro, o webs dependientes de usuarios, que como webs tradicionales.

Origen del término

El término fue acuñado por Dale Dougherty de O'Reilly Media en una lluvia de ideas con Craig Cline de MediaLive para desarrollar ideas para una conferencia. Dougherty sugirió que la web estaba en un renacimiento, con reglas que cambiaban y modelos de negocio que evolucionaban. Dougherty puso ejemplos — "DoubleClick era la Web 1.0; Google AdSense es la Web 2.0. Ofoto es Web 1.0; Flickr es Web 2.0." — en vez de definiciones, y reclutó a John Battelle para dar una perspectiva empresarial, y O'Reilly Media, Battelle, y MediaLive lanzó su primera conferencia sobre la Web 2.0 en Octubre del 2004. La segunda conferencia se celebró en octubre de 2005.

En 2005, Tim O'Reilly definió el concepto de Web 2.0. El mapa meme mostrado (elaborado por Markus Angermeier) resume el meme de Web 2.0, con algunos ejemplos de servicios.

En su conferencia, O'Reilly y Battelle resumieron los principios clave que creen que caracterizan a las aplicaciones web 2.0: la web como plataforma; datos como el "Intel Inside"; efectos de red conducidos por una "arquitectura de participación"; innovación y desarrolladores independientes; pequeños modelos de negocio capaces de redifundir servicios y contenidos; el perpetuo beta; software por encima de un solo aparato.

En general, cuando mencionamos el término Web 2.0 nos referimos a una serie de aplicaciones y páginas de Internet que utilizan la inteligencia colectiva para proporcionar servicios interactivos en red dando al usuario el control de sus datos.

Así, podemos entender como 2.0 -"todas aquellas utilidades y servicios de Internet que se sustentan en una base de datos, la cual puede ser modificada por los usuarios del servicio, ya sea en su contenido (añadiendo, cambiando o borrando información o asociando datos a la información existente), bien en la forma de presentarlos, o en contenido y forma simultáneamente."- (Ribes, 2007)

Mapa mental de la Web 2.0

Tecnología

La infraestructura de la Web 2.0 es muy compleja y va evolucionando, pero incluye el software de servidor, redifusión de contenidos, protocolos de mensajes, navegadores basados en estándares, y varias aplicaciones para clientes.

Una web se puede decir que está construida usando tecnología de la Web 2.0 si se caracteriza por las siguientes técnicas:

Web 2.0 buzz words

Técnicas:

CSS, marcado XHTML válido semánticamente y Microformatos

Técnicas de aplicaciones ricas no intrusivas (como AJAX)

Java Web Start

XUL

Redifusión/Agregación de datos en RSS/ATOM

URLs sencillas con significado semántico

Soporte para postear en un blog

JCC y APIs REST o XML

JSON

Algunos aspectos de redes sociales

Mashup (aplicación web híbrida)

General:

El sitio no debe actuar como un "jardín cerrado": la información debe poderse introducir y extraer fácilmente

Los usuarios deberían controlar su propia información

Basada exclusivamente en la Web: los sitios Web 2.0 con más éxito pueden ser utilizados enteramente desde un navegador

Redifusión de contenido [editar]

La primera y más importante evolución de la Web 2.0 se refiere a la redifusión del contenido de una Web, usando protocolos estandarizados que permitan a los usuarios finales usar el contenido de la web en otro contexto, ya sea en otra web, en un conector de navegador o en una aplicación de escritorio. Entre los protocolos que permiten redifundir se encuentra el RSS (conocido también como RSS 1.1), y Atom, todos ellos basados en el lenguaje XML. Los protocolos específicos como FOAF y XFN (ambos para redes sociales) amplían la funcionalidad de los sitios y permiten a los usuarios interactuar sin contar con sitios Web centralizados. Véase Microformats para más información sobre formatos de datos especializados.

Debido al reciente desarrollo de estos, muchos son de facto en lugar de verdaderos estándares.

Servicios Web

Los protocolos de mensajes bidireccionales son uno de los elementos clave de la infraestuctura de la Web 2.0. Los dos tipos más importantes son los métodos RESTful y SOAP. REST indican un tipo de llamada a un servicio web donde el cliente transfiere el estado de todas las transacciones. SOAP y otros métodos similares dependen del servidor para retener la información de estado. En ambos casos, el servicio es llamado desde un API. A veces este API está personalizado en función de las necesidades específicas del sitio web, pero los APIs de los servicios web estándares (como por ejemplo escribir en un blog) están también muy extendidos. Generalmente el lenguaje común de estos servicios web es el XML, si bien puede haber excepciones.

Recientemente, una forma híbrida conocida como Ajax ha evolucionado para mejorar la experiencia del usuario en las aplicaciones web basadas en el navegador. Esto puede ser usado en webs propietarias (como en Google Maps) o en formas abiertas utilizando un API de servicios web, una semilla de redifusión.

Véase también: WSDL

Software de servidor

La funcionalidad de Web 2.0 se basa en la arquitectura existente de servidor web pero con un énfasis mayor en el software dorsal. La redifusión sólo se diferencia nominalmente de los métodos de publicación de la gestión dinámica de contenido, pero los servicios Web requieren normalmente un soporte de bases de datos y flujo de trabajo mucho más robusto y llegan a parecerse mucho a la funcionalidad de intranet tradicional de un servidor de aplicaciones. El enfoque empleado hasta ahora por los fabricantes suele ser bien un enfoque de servidor universal, el cual agrupa la mayor parte de la funcionalidad necesaria en una única plataforma de servidor, o bien un enfoque plugin de servidor Web con herramientas de publicación tradicionales mejoradas con interfaces API y otras herramientas. Independientemente del enfoque elegido, no se espera que el camino evolutivo hacia la Web 2.0 se vea alterado de forma importante por estas opciones.